Prise de décision : système de décryptage

Nous sommes le 28 mars 1979, il est 4h du matin, les Américains dorment paisiblement et ils sont loin de s’imaginer qu’un accident majeur est sur le point de raser toute la Côte Est des États-Unis !

En effet, la centrale nucléaire de Three Mile Island en Pennsylvanie, subit une série de défaillances matérielles et humaines provoquant une fusion partielle du cœur du réacteur nucléaire. Grâce à l’intervention des spécialistes du domaine (16h d’angoisse), l’accident sera contenu et le pire sera évité (« syndrome chinois ») (NDLR : Fusion du cœur d’un réacteur nucléaire, dans laquelle les éléments combustibles en fusion du cœur — ou corium — percent les barrières qui le confinent et s’enfoncent sous terre) !

À la suite de cet évènement, Jens Rasmussen (ingénieur visionnaire) va décider de réorienter sa carrière vers la fiabilité technique et humaine afin de travailler sur une nouvelle approche capable de capturer la complexité des systèmes sociotechniques à risque (SRK, 1983 ; HA, 1986 ; 1993). Il sera accompagné dans cette démarche par plusieurs chercheurs qui insisteront sur le fait que pour comprendre la genèse des accidents il ne faut pas s’orienter seulement sur les individus (Bremer,1993) mais également remonter jusqu’aux sphères organisationnelles et managériales (Reason, 1990 ; modèle swiss-chease, 1993).

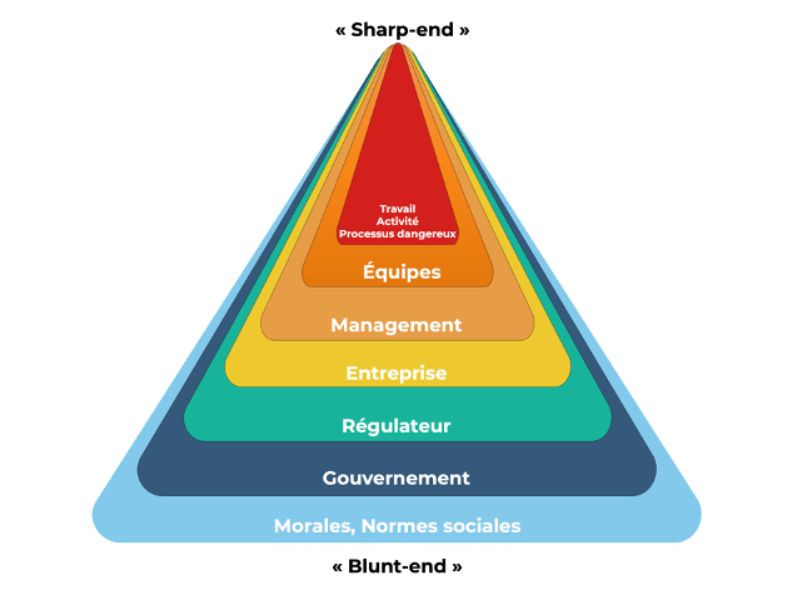

Ces derniers points ont été développé par Woods et al. (1994) qui proposa un modèle (voir figure 1) intégrant la dimension organisationnelle (blunt-end – niveau organisationnel- , contraintes, ressources…) comme source potentielle d’accident et pas seulement le niveau opérationnelle (sharp-end – niveau opérationnel – , défaillance humaine).

Par ailleurs, Rasmussen ajoutera que pour comprendre les stratégies des acteurs du système, il faut connaître les exigences et les contraintes du système auquel ils appartiennent (Rasmussen, 1997 ; Vicente, 1999).

Et en course au large ? L'expérience de Christopher

Ces recherches et cet exemple de l’accident de centrale me font penser toutes proportions gardées aux choix stratégiques que nous faisons en mer. Ils sont largement commentés dans les médias spécialisés ou chez les passionnés qui suivent nos courses.

Lors de la Transat Jacques Vabre 2019, alors que nous étions en tête après 3 jours de course, nous avons longuement (presque 2 jours) hésité entre une route sud et une route ouest. Cela a permis à nos adversaires de prendre un petit avantage sur chacune des deux options. Nous considérions que nous n’avions pas assez d’éléments tangibles pour décider et nous voulions attendre plus d’informations météos, quitte à perdre un peu de terrain.

Ce choix conditionnait la suite de la course et son résultat et nous étions confiants sur la vitesse de notre bateau et notre capacité à rattraper notre petit retard. De plus, la pression du sponsor était importante et nous avions l’étiquette de favoris sur le dos. Cerise sur le gâteau, Jérémie et moi sommes d’un naturel très cartésien. Pour toutes ces raisons, nous avons décidé de ne pas décider.

De l’extérieur, les observateurs plus ou moins aguerris jugeaient ce non-choix comme un aveu de faiblesse ou une hésitation fautive. Ils n’avaient pas l’ensemble des éléments pour pouvoir juger.

Analyses psychologique et systémique, indissociables

Plus récemment, Chauvin et Morel (2013) ont suggéré la nécessité d’adosser une analyse psychologique (micro) à une analyse systémique (macro). Cela dans le but de comprendre les décisions prises par les opérateurs, les arbitrages entre performance et sécurité ainsi que les mécanismes de la gestion des risques.

En mer, chaque choix est indissociable du contexte dans lequel il est fait. Ce n’est pas seulement l’instant T où l’on pourrait parler de circonstances de course, de fatigue ou de problèmes techniques à bord. Il s’agit aussi de l’environnement du projet sportif et de sponsoring global, sa genèse, sa maturité et ses contraintes que seul le skipper et son équipe connaissent réellement. C’est souvent facile de juger un choix stratégique depuis son canapé, de fustiger un skipper pour une mauvaise stratégie météo, mais en réalité il est impossible de connaître les éléments qui entrent en compte dans ladite décision.

Pour aller plus loin

- Reason, J. (1993). New approaches to organisational safety. In B. Wilpert & T. Qvale (Eds.), Reliability and safety in hazardous work systems (pp. 7-22). Hillsdale, NJ, England: Lawrence Erlbaum Associates.

- Woods, D.D., Johannsen, L., Cook, M., & Sarter, N. (Eds.). (1994). Behing Human Error. Dayton OHIO: WPAFB, CERSIAC SOAR 94-01.

- Chauvin, C., & Morel, G. (2013). Gestion des risques et prise de décision : articulation de modèles systémiques et psychologiques. In B. Cadet, A. Smida, & G. Chasseigne (Eds.), Ethique, Risque et Décision. Editions Publibook Université.